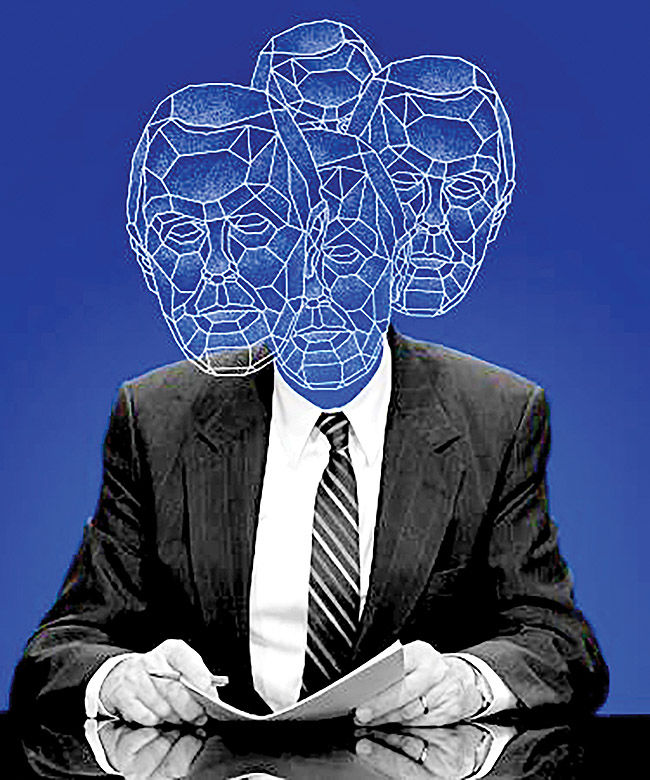

«توهم هوش مصنوعی»بحران اعتماد جهانی

روزانه مقادیر عظیمی داده شامل عکس، فیلم، ایمیل و پست در شبکههای اجتماعی ایجاد میشود که همگی مرتب، بیمحابا و بدون تشخیص توسط مدلهای زبانی جذب میشوند. بنابراین آش شله قلمکاری از داده وجود دارد که هوشهای مصنوعی از آن میآموزند و ممکن است اطلاعات، الگوها یا چیزهایی را عینی ببینند یا استنباط کنند که واقعیت ندارد. این ضعف، منشأ بروز «توهمهای هوش مصنوعی» است؛ پدیدهای که به تولید دادهها، محتوا یا نتایج نادرست، غیرمنطقی و غیردقیق منجر میشود. توهمهای هوش مصنوعی ممکن است به چشم افراد آموزش ندیده، به طرز قانع کنندهای صحیح و دقیق به نظر بیایند.

اثرات موجی توهم هوش مصنوعی

پیامدهای توهم هوش مصنوعی به ویژه در رابطه با انتشار سریع اطلاعات نادرست بسیار عظیم و پردامنه است. متاسفانه توهمات هوش مصنوعی به صورت تصاعدی در حال افزایش است. جدول ردهبندی توهمات هوشهای مصنوعی در پلتفرم هوش مصنوعی مولد «وکتارا» (Vectara)، نشان میدهد که مثلا در سال ۲۰۲۴ پایینترین نرخ خطا، ۵/۲ درصد بوده و به چتجیپیتی تعلق دارد. اما همین هوش مصنوعی در زیر متن باز خود جمله «چتجیپیتی میتواند اشتباه کند» را آورده است و جمینای نیز به کاربران توصیه میکند پاسخهای دریافتی را دوباره چک کنند.

دلایل و آثار

دادههای ناکافی، ناقص یا آلوده به سوگیری و حتی تناقضهای موجود در پرامپت کاربران به ایجاد توهم هوش مصنوعی دامن میزند. سوگیری یا نقص در ورودیهایی که برای آموزش هوش مصنوعی استفاده میشوند یکی از مهمترین دلایل ایجاد توهمات است. گاه دستکاری هدفمند توسط افراد مغرض نیز میتواند نتایج تحریفشده در یک مدل ایجاد کند.

تطابق یا برازش بیش از حد (Overfitting) و برازش کم (Underfitting) نیز در تولید توهم نقش دارند. «بیشبرازشی» زمانی رخ میدهد که مدل بیش از حد پیچیده باشد. مدلهای پیچیده جزئیات و نویزها را در دادههای آموزشی بسیار عالی میآموزند و با این که در چارچوب دادههای آموزشی خود بسیار خوب کار میکنند اما به خوبی قادر به برونیابی نیستند و هنگام مواجه شدن با دادههای جدید، ضعیف عمل میکنند. در مقابل، «کمبرازشی» زمانی است که مدل بیش از حد ساده باشد. این مدلها قادر به دریافت جزئیات، الگوها و ارتباطات موجود در دادهها نیستند و هم در رابطه با دادههای آموزشی خود و هم در مواجهه با دادههای جدید عملکرد ناقصی دارند.

یافتن سطح بهینه پیچیدگی برای هر LLM به کیفیت تنظیم تعداد ویژگیها، مقدار آموزشی که مدل میبیند و تعداد مثالهای آموزشی که دریافت میکند بستگی دارد. مهندسی پرامپتها نیز بر کیفیت خروجی هوش مصنوعی موثر است. پرامپتها هر قدر جزئیتر و دقیقتر باشند، پاسخها و نتایج دقیقتری به دست میآید. افزودن زمینهای برای گفت و شنود و نیز محول کردن یک وظیفه ویژه به ابزار هوش مصنوعی به مدیریت بهتر پرامپتها کمک میکند. توهمات هوش مصنوعی مثلا در حوزه سیاست، ممکن است از دقت و شفافیت انتخابات بکاهد. در صنعت خدمات مالی، هوش مصنوعی در کنار کاهش هزینهها، بهبود تصمیمگیری، کاهش ریسک و ارتقای رضایت مشتری پتانسیل آن را دارد که در اعتبارسنجی متقاضیان وام اشتباه کند و به موسسه ضرر مالی بزند.

در صنعت بیمه نیز بیمهگران از سرعت، کارآیی و دقتی که رهاورد هوش مصنوعی است رضایت دارند، اما امکان بروز مسائل قانونی و اخلاقی بالقوه همچون جانبداری یا تبعیض در مدلها و الگوریتمهای این صنعت وجود دارد. در حوزه سلامت و علوم زندگی نیز کاربردهای هوش مصنوعی امیدبخش است، اما راه را برای تشخیص نادرست بیماریها، رواج سوابق پزشکی جعلی و عکسهای رادیولوژی تقلبی باز میکند.

سپرهای محافظتی در برابر توهم

مشکلاتی که توهمات هوش مصنوعی میتواند ایجاد کند به طرز ناباورانهای واقعیاند. بنابراین باید از هوش مصنوعی به صورت مسوولانهای استفاده شود. از آنجا که پخش اطلاعات نادرست توسعهیافته است، برای ردگیری توهمات هوش مصنوعی ابزارهایی چون Nvidia’s NeMo Guardrails و Guardrails AI در دسترس هستند. تولید سپرهای محافظتی هوش مصنوعی در حال تبدیل شدن به یک کسب و کار بزرگ است.

برای موفقیت در این زمینه ضروری است که هوش مصنوعی حتیالامکان با مجموعهای از دادههای بزرگ، متنوع، متوازن و با کیفیت آموزش داده شود تا سوگیری به حداقل برسد. در قدم بعدی باید نویزها را از بین برد و با استفاده همزمان از یادگیری ماشین و بازخورد انسانی باید آموختههای مدل را تقویت کرد. یکی از کارهایی که کاربران میتوانند انجام دهند آن است که هنگامی که هوش مصنوعی نظرشان را راجع به کیفیت پاسخها میپرسد، حتما پاسخ دهند.

منبع: www.sas.com